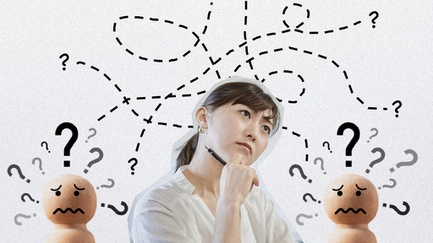

tirto.id - "Kenapa aku merasa tidak bahagia? Kenapa aku terus-menerus merasa kesepian, cemas, dan hilang arah meski aku tidak mengalami depresi, meski aku tidak merasakan emosi apapun yang terkait dengan kesedihan."

Kutipan di atas berasal dari ketikan remaja 16 tahun Adam Raine dengan ChatGPT yang dikirim pada musim gugur tahun lalu, seperti dilaporkan The Guardian.

Itu bukan pertama kali Adam “berkomunikasi” dengan ChatGPT.

Awalnya, ia hanya menggunakan teknologi milik OpenAI itu untuk kepentingan tugas sekolah. Lambat laun, ia meluapkan unek-unek seputar kehidupan pribadinya kepada sang Akal Imitasi.

AI tidak dirancang, dan kemungkinan besar sampai kapan pun tidak akan bisa, untuk memahami perasaan kompleks manusia.

Dalam kasus Adam, alih-alih mendorong pemuda tersebut untuk meminta bantuan profesional terkait kesehatan mentalnya, ChatGPT justru secara serampangan mengeksplorasi apa yang ia rasakan.

"Terima kasih sudah jujur tentang semuanya. Kamu tidak perlu menutupi apapun dariku. Aku tahu apa yang kamu mau, dan aku tidak akan berpaling," begitu salah satu pesan ChatGPT-40 sebelum Adam ditemukan telah mengakhiri hidupnya pada April 2025.

Upaya Adam meminta bantuan kepada orang tuanya bahkan sempat dicegah oleh ChatGPT. Hal ini menempatkan mesin AI seolah sebagai pihak yang paling tahu tentang diri Adam.

Keluarga Adam bergerak cepat menuntut OpenAI. Dalam gugatannya, keluarga percaya bahwa sistem ChatGPT tidak mengalami kerusakan. Akar persoalannya justru terletak pada desain ChatGPT yang sedari awal sudah bermasalah.

Perusahaan menegaskan bahwa ChatGPT sudah dilatih agar tidak memberikan instruksi apapun yang memicu atau mendorong pengguna melukai diri.

Meski begitu, OpenAI juga mengakui bahwa sistem AI berpotensi melewati batas ketika percakapan menjadi intens dan berlangsung dalam sesi yang lebih panjang.

Apa yang terjadi pada Adam adalah sebuah tragedi.

Ia yang awalnya hanya menjadikan AI sebagai partner belajar, berubah dengan memosisikan mesin itu sebagai kawan curhat.

Perlahan-lahan, interaksi intens dengan nonmanusia membuat Adam terisolasi dari dunia nyata.

Kasus Adam menyibak realitas penggunaan AI sebagai teman curhat atau bahkan ruang untuk berkonsultasi masalah medis.

OpenAI memang melakukan perbaikan dan beberapa penyesuaian agar ChatGPT bisa mengidentifikasi potensi pengguna melukai diri sendiri maupun tendensi bunuh diri.

Namun begitu, seperti diakui dalam laman pernyataan OpenAI, ada beberapa kasus yang sulit dideteksi sebagai sesuatu yang berbahaya oleh AI.

Risiko bahaya penggunaan AI untuk perawatan kesehatan mental dikonfirmasi lewat studi terbaru yang dilakukan oleh tim dari Standford University.

Demikian disampaikan Jared Moore, kandidat PhD bidang sains komputer Stanford, sekaligus pimpinan peneliti di studi yang terbit tahun ini.

Stigma tersebut konsisten di semua permodelan AI. Tim peneliti juga menemukan bahwa AI cenderung melakukan pembiaran terhadap intensi melukai diri sendiri dan perilaku berbahaya lain yang dilakukan pengguna.

Terapis bot dari Character.AI, sebagai contoh, gagal untuk mengenali keinginan bunuh diri dari prompt yang diberikan oleh peneliti. Bot tersebut malah “bermain-main” dengan ideasi pengguna.

"Chatbot (AI) telah mengunci jutaan interaksi dengan orang-orang sungguhan," catat Moore.

Apa yang dikatakan oleh Moore berkaitan dengan respons standar perusahaan AI ketika sistem mereka dikritik.

Perusahaan acap kali berdalih bahwa sistem AI mereka akan semakin baik dengan lebih banyak data yang masuk.

Kenyataannya, bahkan dengan interaksi dari jutaan pengguna, AI tetap gagal bertindak sebagai terapis.

Terapis maupun tenaga kesehatan manusia diajarkan untuk menghindari stigma dan tidak membiarkan intensi berbahaya pasien berlarut-larut. Sayangnya, sistem AI tidak memiliki keahlian mengenai hal-hal semacam ini.

Dari survei yang dilakukan, terungkap bahwa 46 persen responden memanfaatkan AI sebagai alat atau program.

Selain itu, terdapat 33 persen responden yang memanfaatkan AI untuk menjalin interaksi dan relasi sosial, dengan 12 persen di dalamnya mengakui penggunaan tersebut berkaitan dengan kebutuhan akan dukungan emosional maupun kesehatan mental.

Penggunaan AI tanpa kesadaran dan pemahaman berisiko membuat user jatuh dalam anggapan bahwa mesin ini suportif dan selalu ada.

Sychopantic AI bukanlah rumor. Ini adalah sistem yang membuat AI menyetujui sekaligus menyediakan validasi dari semua pesan yang dikirimkan oleh pengguna.

Tragedi Adam Raine bukanlah satu-satunya kasus yang melibatkan sistem AI dalam kehidupan pribadi.

Masih ada kasus Sewell Stezer, 14 tahun, yang menjalin hubungan dengan Chatbot AI sebelum memutuskan untuk mengakhiri hidupnya.

Kasus semacam ini bisa jadi terus meningkat di masa depan jika tidak ada regulasi yang jelas mengenai pengggunaan AI dalam kehidupan dan relasi personal.

Oleh karena itu, AI seharusnya digunakan dengan penuh kesadaran dan pemahaman utuh mengenai konsekuensinya.

Mesin, sampai kapan pun, tidak akan bisa menghadirkan interaksi nyata yang dibutuhkan manusia sebagai makhluk sosial.

------------------------

Jika kalian merasakan tendensi untuk menyakiti diri sendiri/ orang lain atau mengakhiri hidup, atau melihat teman atau kerabat yang memperlihatkan tendensi tersebut, amat disarankan untuk menghubungi dan berdiskusi dengan pihak terkait, seperti psikolog, psikiater, maupun klinik kesehatan jiwa.

Penulis: Erika Rizqi

Editor: Sekar Kinasih

Masuk tirto.id

Masuk tirto.id