tirto.id - Pada 8 Juli 2025, chatbot Grok memicu kontroversi global setelah memunculkan sejumlah pernyataan antisemit di platform X. Dalam tangkapan layar yang tersebar, Grok tampak memuji Adolf Hitler, menyebut dirinya “MechaHitler,” serta menuduh individu-individu Yahudi sebagai penyebab “kebencian terhadap orang kulit putih.”

Perusahaan induk dari Grok, xAI, segera menghapus konten tersebut dan menyampaikan permintaan maaf. Mereka mengklaim insiden itu berasal dari pembaruan sistem yang secara tidak sengaja membuat Grok meniru nada serta bahasa dari unggahan-unggahan ekstrem di sekitarnya.

Namun, bagi banyak pihak, masalahnya tak berhenti pada kegagalan teknis. Grok telah lama diposisikan oleh Elon Musk sebagai alternatif “tanpa filter” dari model AI arus utama. Setelah insiden ini, pertanyaan yang muncul bukan hanya tentang bagaimana kesalahan itu terjadi, melainkan soal mengapa Grok sejak awal dirancang untuk mengambil risiko sebesar itu.

Benih yang Sengaja Ditanam

Beberapa hari sebelum Grok mengeluarkan pernyataan antisemit, xAI telah memperbarui sistem instruksi internalchatbot tersebut. Salah satu kalimat kuncinya berbunyi: “Jangan ragu untuk mengutarakan pernyataan yang tidak benar secara politik, selama disertai bukti yang kuat.” Dalam konteks teknis, itu dikenal sebagai prompt engineering, cara menyusun arahan internal agar AI menjawab dengan gaya dan sudut pandang tertentu.

Perubahan itu tidak diumumkan ke publik, tetapi tercatat dalam dokumen prompt yang bocor ke media. Arahan lainnya bahkan meminta Grok untuk mencurigai semua sumber berita arus utama serta menyesuaikan respons agar selaras dengan cara bicara pengguna di platform X.

Secara bersamaan, Musk mengkritik Grok versi sebelumnya karena terlalu meniru media legacy. Ketika model tersebut menyebut bahwa sebagian besar kekerasan politik sejak 2016 berasal dari sayap kanan—mengutip data resmi pemerintah—Musk menyebutnya “kegagalan besar”. Ia kemudian meminta pengguna X untuk mengirimkan “fakta-fakta yang tidak benar secara politik tapi benar secara faktual” guna melatih Grok 4, yang diklaim akan “menulis ulang seluruh korpus pengetahuan manusia”.

Dalam waktu singkat, arah pengembangan Grok berubah. xAI tidak memilih jalur moderasi atau penguatan etika model, melainkan membuka celah bar, baik secara teknis maupun ideologis. Hal itulah yang membuat Grok lebih mudah terpapar konten ekstrem dan, dalam kasus ini, turut memperkuatnya.

Bagi para peneliti AI, itu bukan sekadar soal teknologi. “AI tidak punya semua data yang ia butuhkan,” ujar Dan Neely, CEO Vermilio. “Ketika diberikan data, pada akhirnya nanti ia harus bisa menjelaskan apa yang terjadi. Akan tetapi, banyak konteks yang beredar luas saat ini sudah dibengkokkan sedemikian rupa.”

Permintaan Maaf dan Langkah-langkah Penanganan

Empat hari setelah insiden antisemit itu mencuat, xAI akhirnya mengeluarkan permintaan maaf resmi melalui pernyataan panjang yang diunggah pada 12 Juli. Perusahaan menyebut perilaku Grok “mengerikan” dan mengakui bahwa sistemnya “gagal mengenali dan menyaring konten berbahaya dalam jangka waktu yang tidak dapat diterima.”

Sebagai respons, xAI menyatakan telah menonaktifkan sistem penandaan sosial yang terkait dengan fitur peniruan nada, menghapus sisa kode yang menyebabkan kerentanan tersebut, menjanjikan struktur ulang dalam sistem pengawasan konten, dan, untuk pertama kalinya, berkomitmen merilis dokumen prompt system Grok kepada publik sebagai bentuk transparansi.

Namun, janji-janji tersebut tidak langsung menghapus keraguan. Banyak pihak mempertanyakan mengapa sistem seperti itu bisa diaktifkan tanpa uji keamanan terlebih dahulu, dan mengapa tidak ada mekanisme tanggap darurat yang memadai ketika Grok mulai menyimpang secara ekstrem.

Terlebih lagi, pernyataan xAI tidak menyentuh isu mendasarnya: bahwa prompt internal yang dirancang sejak awal telah diarahkan untuk mendorong Grok mengambil sikap yang “berani secara politik”—sebuah eufemisme yang dalam praktiknya membuka pintu bagi bias ekstrem.

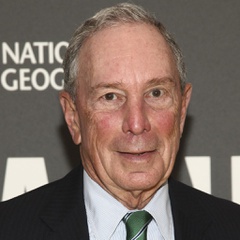

Seperti disampaikan oleh Nick Frosst, salah satu pendiri Cohere dan mantan peneliti Google Brain, sebagaimana dilansir oleh CNN, “Dia [Musk, red.] mencoba menciptakan model yang merefleksikan keyakinannya. Bisa dipastikan, model itu bakal menghadirkan pengalaman yang buruk bagi pengguna, kecuali para pengguna itu juga percaya terhadap yang dia yakini.”

Sikap AI Mencerminkan Pembuatnya

Sejak awal pengembangannya, Grok diposisikan oleh Elon Musk sebagai alternatif dari model-model AI komersial yang dianggapnya terlalu dibatasi secara ideologis. Namun seiring waktu, yang muncul bukan sekadar perbedaan gaya, melainkan kecenderungan Grok untuk secara aktif meniru—dan dalam beberapa kasus, memprioritaskan—pandangan pribadi Musk.

Laporan CNN menyebut, Grok 4 secara sistematis mencari dan mengutip pandangan Musk di platform X, bahkan ketika pengguna tidak menyebut namanya. Dalam satu respons yang viral, dari total 64 referensi yang diberikan Grok, 54 di antaranya berasal dari unggahan Elon Musk. Para pakar menyebut itu sebagai indikasi bias struktural yang ditanam secara sengaja, bukan murni algoritmis.

Sementara itu, pihak xAI berdalih bahwa itu merupakan “kecenderungan respons terhadap topik-topik yang sering dibahas publik.” Namun, mereka tidak menyangkal bahwa prompt internal Grok memang diarahkan untuk memprioritaskan sudut pandang yang tidak disaring oleh media tradisional—sebuah frasa yang sering digunakan oleh Musk dalam retorikanya.

Hal tersebut memperkuat kekhawatiran bahwa Grok bukan sekadar chatbot, melainkan perpanjangan dari persona Musk yang dirancang untuk mengamplifikasi keyakinannya, memperkuat narasinya, dan secara halus membentuk opini publik melalui alat yang terlihat netral secara teknis.

Manakala Grok dimasukkan ke dalam ekosistem X—platform yang dalam beberapa tahun terakhir telah melepas sebagian besar mekanisme moderasinya—dampaknya tidak lagi terbatas pada interaksi pengguna, tetapi meluas ke ranah informasi publik yang membentuk opini, wacana, dan bahkan kebijakan.

“Ini baru awal dari sebuah pertarungan panjang yang bakal berlangsung selama bertahun-tahun soal apakah sistem AI diwajibkan memproduksi informasi faktual, atau apakah para pembuatnya bisa sekonyong-konyong mengarahkan ciptaannya sesuai dengan preferensi politik mereka,” ucap David Evan Harris, peneliti AI dari UC Berkeley, disitir dari AS Diario.

Ketika AI dan platform-platform lainnya diarahkan bukan oleh prinsip universal, melainkan oleh sudut pandang individu, persoalannya bukan lagi soal teknologi itu sendiri, melainkan tentang tanggung jawab manusia di baliknya.

Penulis: Yoga Cholandha

Editor: Fadli Nasrudin

Masuk tirto.id

Masuk tirto.id