tirto.id - Sejak akhir dekade 1950-an, Central Intelligence Agency (CIA) berusaha membendung pengaruh komunis di berbagai negara, termasuk Indonesia. Dalam “Summary of Facts: Investigation of CIA Involvement in Plans to Assassinate Foreign Leaders,” laporan komisi yang dibentuk Presiden Gerald Ford pada 1975 untuk menyelidiki operasi CIA, disebutkan agen-agen intelijen Paman Sam itu pernah berencana membunuh para pemimpin dunia, selain Fidel Castro (Presiden Kuba) dan Rafael Trujillo (Presiden Dominika), juga Presiden Sukarno.

Rencana CIA membunuh para pemimpin dunia yang diduga terpengaruh paham komunis tak jadi dilaksanakan lantaran Richard Nixon, yang saat itu menjabat wakil presiden Amerika Serikat, tidak setuju dengan kehendak CIA. Namun, khusus Presiden Sukarno, CIA tidak hanya berniat membunuhnya, tetapi juga menghancurkan karakternya. Karena dikenal mudah jatuh hati pada perempuan, CIA berencana membuat film porno yang aktor prianya mirip dengan sang Pemimpin Besar Revolusi. Film porno berwajah mirip Sukarno diciptakan sebagai bahan tuduhan bahwa Sukarno mempermalukan diri dengan meniduri agen Soviet yang menyamar sebagai pramugari maskapai penerbangan.

Dalam usaha menciptakan film porno beraktor mirip Sukarno, CIA meminta bantuan salah satu studio Hollywood yang dioperasikan Bing Crosby. Karena di dekade tersebut teknologi Computer-generated imagery (CGI) belum tersedia, CIA menunjuk seorang pria Chicano yang dianggap mirip Sukarno untuk menjadi aktor pria film porno tersebut.

Untunglah, film porno garapan CIA untuk merusak citra Sukarno tidak jadi dirilis. Karena, jika dirilis, yang sesungguhnya akan malu dengan strategi konyol ini bukanlah Sukarno, melainkan CIA sendiri. Alasannya, jika Anda melakukan pencarian “Chicano” di Google, istilah yang ditujukan bagi mereka orang-orang Meksiko yang lahir di Amerika Serikat itu secara umum tidak memiliki bentuk kemiripan dengan orang Asia. Maka, mudah bagi penonton untuk mengidentifikasi bahwa aktor Chicano mirip Sukarno yang dikehendaki CIA sebagai “Sukarno”, bukanlah Sukarno.

Namun, andai saja CIA menunda perilisan film yang tertuang dalam strategi busuk mereka sekitar 60 tahun, CIA punya dua alat untuk memudahkan mereka menciptakan film porno yang aktor prianya benar-benar mirip Sukarno, tanpa perlu bantuan orang-orang Chicano. Pertama, seperti disinggung di atas, CIA dapat menggunakan teknologi CGI. Namun, teknologi ini cukup mahal dan mungkin akan membuat publik AS marah gara-gara uang pajak mereka dipakai untuk membuat film porno.

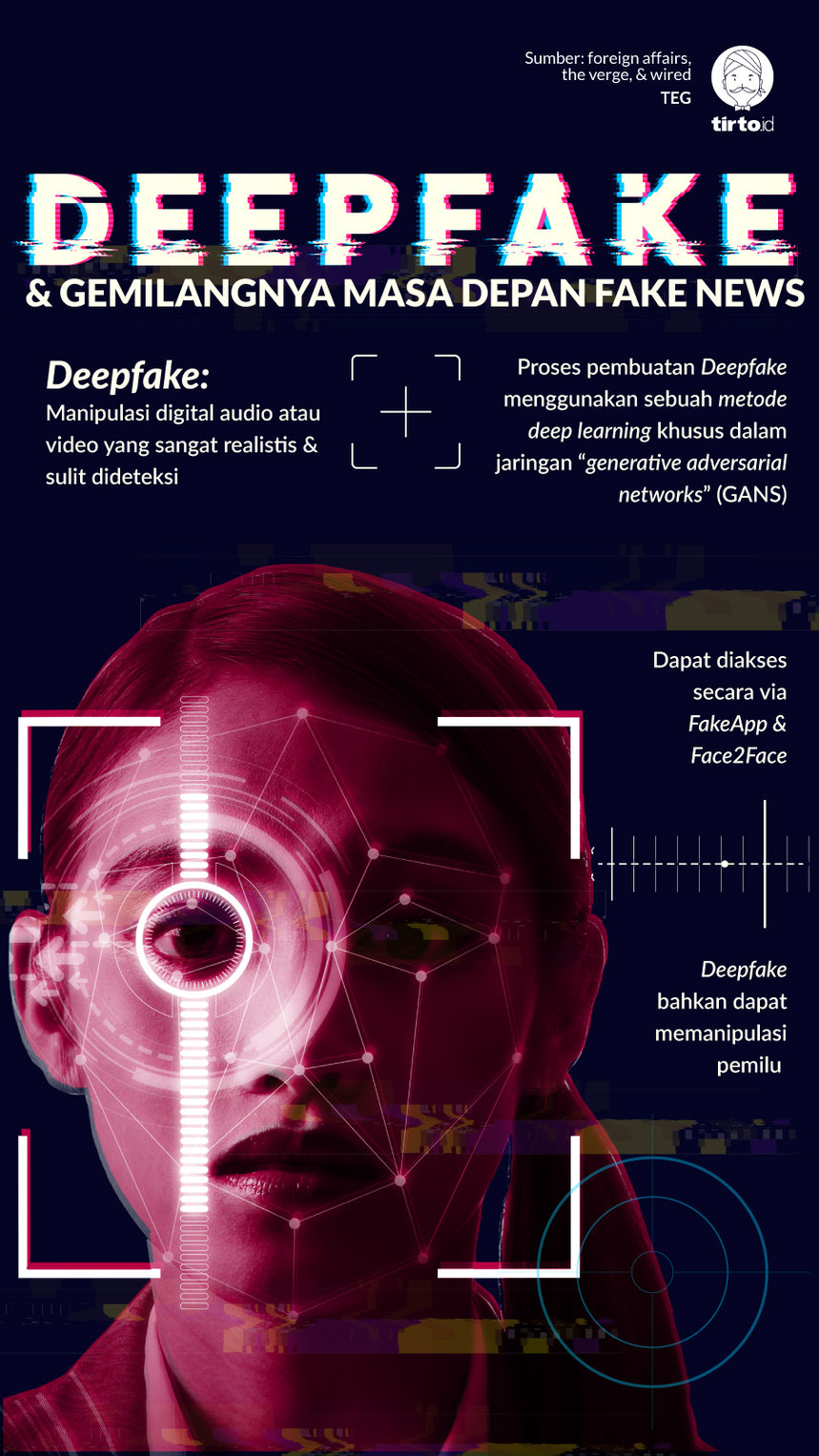

Kedua, dengan biaya yang sangat murah, CIA dapat menggunakan teknologi bernama deepfakes.

Deepfakes: Tidak Sederhana, Tapi Tak Serumit Membuat Roket

Salah satu sosok pertama yang menjadi korban film porno yang memanfaatkan deepfakes bukan Sukarno, melainkan Gal Gadot. Jika Anda meluncur ke Pornhub--untuk tujuan jurnalistik, tentu saja--dan mengetik “Gal Gadot” di kolom pencarian website tersebut, artis asal Israel pemeran Wonder Woman itu muncul di beberapa video porno di Pornhub. Tentu saja itu bukan Gal Gadot sungguhan. Melalui teknologi deepfakes, foto-foto Gal Gadot yang jumlahnya jutaan di dunia maya direkayasa, ditimpa/ditempelkan pada wajah pemeran perempuan film porno.

Sejauh ini, lapor Samantha Cole untuk Motherboard, selain Gadot, artis Hollywood lain seperti Scarlett Johansson, Maisie Williams, Taylor Swift, dan Aubrey Plaza jadi korban rekayasa teknologi deepfakes.

Meskipun sama-sama dapat digunakan untuk rekayasa, deepfakes dan CGI berbeda secara teknis. CGI lebih mirip teknik animasi tradisional. Dalam teknik animasi tradisional, suatu gerakan dibuat melalui rangkaian gambar-gambar yang saling bertautan umumnya dalam ritme 24 fps (frame per second), alias 24 gambar yang dirangkai untuk menciptakan animasi dalam tempo 1 detik. CGI mempermudah kerja animasi tradisional dengan memanfaatkan komputer. Di sisi lain, deepfakes merupakan teknik rekayasa video yang memanfaatkan kecerdasan buatan, khususnya machine learning. Terdapat algoritma khusus yang digunakan untuk melatih machine learning agar mampu memahami gerak wajah seseorang di video dan membandingkannya dengan foto-foto yang disediakan sebagai basis data.

Face2Face merupakan salah satu algoritma untuk melakukan rekayasa video dengan teknik deepfakes. Salah seorang penulis kode Face2Face yang berbicara pada Cole menyebut rekayasa melalui deepfakes pertama-tama dilakukan dengan mengumpulkan sebanyak-banyaknya foto dari sosok yang wajahnya hendak diganti (sebut saja “A”). Lalu, foto-foto itu kemudian didistorsi--semacam dirusak--dan diberikan sebagai basis data untuk melatih machine learning. Machine learning pun menganalisisnya.

Ketika machine learning kemudian diberikan sebanyak-banyaknya foto-foto sosok yang hendak diambil wajahnya (foto-foto ini juga sengaja didistorsi, dan sebut saja “B”), machine learning semacam dibodohi. Machine learning menganggap foto-foto dari sosok yang wajahnya hendak diganti (“A”) dan foto-foto dari sosok yang wajahnya hendak digunakan (“B”), sama. Terakhir, karena menganggap bukan wajah sosok berbeda, machine learning akan merangkai/menempelkan secara otomatis wajah sosok yang dipakai (“B”) ke video dari sosok yang wajahnya hendak diganti (“A”) yang telah disiapkan.

Rekayasa video melalui deepfakes terdengar rumit. Namun, karena zaman ini banyak manusia yang mengunggah foto wajah mereka dengan sukarela ke internet dan semakin murahnya menyewa mesin yang dapat melakukan proses machine learning (bahkan kini muncul versi open source seperti TensorFlow), deepfakes jauh lebih mudah dikuasai. Kevin Roose, jurnalis Teknologi The New York Times, telah membuktikannya.

Berbekal aplikasi bernama FakeApp (semacam aplikasi yang telah mengandung algoritma deepfakes seperti Face2Face), Roose sukses menciptakan video rekayasa

Ryan Gosling dan beberapa artis Hollywood hanya dalam tempo 3 hari dan dengan biaya senilai $85,96. Biaya yang dibayarkan untuk menyewa Google Cloud Platform, layanan dari Google yang memungkinkannya menjalankan machine learning--menjalankan TensorFlow.

Untuk “membodohi” kecerdasan buatan, membuat machine learning berpikir bahwa wajah Roose sama dengan wajah Ryan Gosling, Roose “memberi makan” machine learning 417 foto dirinya dan 1.113 foto Ryan Gosling. Klaim Roose, “Yang saya pelajari, membuat video rekayasa dengan teknik deepfakes tidaklah sederhana. Tetapi deepfakes juga bukan ilmu yang rumit.”

Jika Anda melihat video-video rekayasa yang memanfaatkan deepfakes, video yang dihasilkan memang tidak sesempurna hasil kerja CGI membuat Princess Leia dalam Rogue One muda kembali. Deepfakes hanya menghasilkan video rekayasa dengan hasil maksimal “cukup”.

Namun, karena tidak rumit dan membutuhkan biaya yang murah, deepfakes sangat berbahaya. Sangat mengerikan jika deepfakes masuk ke ranah politik. Deepfakes dapat digunakan untuk menjatuhkan pribadi seseorang dengan video rekayasa, persis seperti yang direncanakan CIA pada Presiden Sukarno.

Tentu, karena kualitas video yang dibuat menggunakan deepfakes belum sempurna, sangat mungkin penontonnya mengidentifikasi kepalsuan. Masalahnya, otak manusia lemah. Ketika disajikan video, yang meskipun rekayaan, tentang seseorang, otak penontonnya sangat mungkin akan berpikir "seeing is believing".

Seeing is Believing

Pada 2018 lalu, negeri Gabon menghadapi situasi politik yang aneh. Menurut laporan Mother Jones, keanehan muncul manakala sang pemimpin, Presiden Ali Bongo, yang pergi ke Arab Saudi dan Inggris untuk menjalani pengobatan sejak Oktober 2018, tak pulang-pulang dan tak kunjung muncul di media.

Spekulasi berkembang, meskipun pemerintah menyebut Presiden Bongo baik-baik saja dan tak bisa muncul di publik karena stroke. Sebagian rakyat Gabon meyakini kondisi kesehatan sang presiden sudah sangat akut. Sebagian lain, mempercayai bahwa Presiden Bongo telah meninggal dunia. Ada pula yang percaya Bongo baik-baik saja, tetapi ada perseteruan elite yang membuatnya mengurung diri. Untuk yang terakhir, spekulasi muncul karena militer negeri itu mengumumkan telah gagal melakukan kudeta, tidak lama setelah rumor berkembang.

Tatkala Presiden Bongo menyapa rakyat Gabon pada tahun baru 2019 melalui video, spekulasi bahkan makin menggila. Semakin banyak orang yakin kesehatan Bongo tidak baik-baik saja. Bruno Ben Moubamba, politikus Gabon yang pernah dua kali mencalonkan diri menjadi presiden, bahkan percaya bahwa video sang presiden palsu. Moubamba menilai, video Presiden Bongo menyapa rakyatnya di tahun baru bukanlah sang presiden sebenarnya, melainkan orang lain yang memanfaatkan deepfakes dengan menggunakan wajah Bongo.

Masih merujuk laporan Breland, keyakinan Mobamba bahwa video Presiden Bongo adalah deepfakes terjadi karena ia menilai wajah dan mata sang presiden “tak bergerak”. Lalu, hampir sepanjang video itu hanya menampilkan “wajah dari sisi dagu” dan gerakan mulut serta wajahnya “tidak serasi”.

“Dengan keanehan-keanehan di elemen wajahnya, ini terlihat sekali mengarah pada ciri-ciri video deepfakes,” klaim Mobamba. Beberapa pakar yang dihubungi Breland, selepas diperlihatkan video Bongo, bahkan kebingungan membedakan apakah benar bahwa video tersebut asli atau deepfakes. Hany Farid, profesor ilmu komputer pada Dartmouth University, misalnya, menyatakan menonton beberapa video Presiden Bongo lainnya dan bahwa "video ini tidak menyerupai pola ucapan dalam video presiden yang lalu, dan bahkan penampilannya pun tidak terlihat sama”.

Jika benar bahwa video kemunculan Presiden Bongo adalah rekaan deepfakes, Presiden Bongo artinya dalam kondisi kesehatan yang gawat (dengan merujuk pernyataan resmi pemerintah bahwa ia memang tengah sakit, bukan karena ketegangan politik), yang tak memungkinkannya memegang kekuasaan. Dalam konstitusi Gabon, ketika presiden dalam kondisi demikian, Presiden Senat Gabon--setara Ketua DPR di Indonesia--wajib mengambil alih kekuasaan, dan dalam tempo 60 hari Presiden Senat Gabon diperintahkan untuk menyelenggarakan pemilu, mengganti presiden yang dianggap “cacat” secara konstitusi.

Untunglah, plot twist muncul. Dunia politik Gabon tak jadi gempar. Hingga hari ini, Bongo masih memimpin di Libreville.

Tatkala negeri Paman Sam hendak memulai perjalanan panjang pemilihan umum untuk mencari presiden baru, sebuah video yang menampakkan sosok politikus Demokrat sekaligus Ketua DPR AS Nancy Pelosi muncul ke publik. Bukan video bersuasana menggembirakan seperti video-video Alexandria Ocasio-Cortez tentu saja, melainkan video yang menampakan Pelosi berbicara aneh, terbata-bata, seperti orang mabuk. Dalam video yang direkam dalam suatu konferensi pers itu, Pelosi terdengar kacau. Gagap.

Sarah Mervosh, dalam laporannya untuk The New York Times, menyebut bahwa video tak elok dari Pelosi menyebar cepat di AS, melalui saluran Twitter, Youtube, hingga Facebook. Dan karena Pelosi adalah seorang Demokrat, video itu kemudian jadi bahan bakar serangan orang-orang Republik, tak terkecuali netizen bernama Donald Trump. Trump, yang saat video itu muncul hingga hari ini masih berstatus Presiden AS, mengunggah ulang video Pelosi, lengkap dengan keterangan “gagap”, yang ia tulis dengan capslock.

Diliputi keraguan apakah video Pelosi itu benar atau palsu di publik AS, Siwei Lyu, profesor ilmu komputer pada State University of New York, menyebut video negatif tentang Pelosi kemungkinan telah diedit, dengan meningkatkan frekuensi rendah audionya, sambil merusak visual Pelosi yang sedang berbicara. Menurut Lyu, video Pelosi itu diciptakan aplikasi semacam deepfakes. Jika deepfakes memanipulasi video, yang terjadi dalam video Pelosi adalah manipulasi audio.

Kemunculan video-video rekaan yang dipermudah dan dipermurah penciptaannya melalui deepfakes jelas berbahaya, entah dalam bentuk video porno atau video yang bertujuan untuk melakukan provokasi politik. Ya, video-video rekaan, baik dibuat menggunakan deepfakes maupun teknik lainnya, terkadang mudah dikenali. Mudah dipatahkan keasliannya. Masalahnya, sebagaimana dipaparkan Brian Resnick untuk Vox, otak manusia sangat mudah diyakinkan kebenaran suatu peristiwa--meskipun bohong/palsu dan mudah dipatahkan--melalui bentuk-bentuk visual, foto atau video.

Pada 2010, misalnya, Slate melakukan riset kecil-kecilan untuk membuktikan lemahnya otak manusia dengan membagikan foto Presiden Barack Obama yang tengah berjabat tangan dengan Presiden Mahmoud Ahmadinejad kepada 1.000 pembacanya. Foto itu jelas palsu dan dibuat menggunakan Photoshop. Namun, ketika 1.000 pembaca Slate itu ditanya “apakah para pembaca mengingat peristiwa ini?”, 21 persen menjawab iya. Sementara itu, 25 persen lainnya mengatakan mereka mengingat peristiwa tersebut, tetapi mengatakan tidak ingat secara spesifik kapan mereka melihatnya untuk pertama kali.

Bagi orang-orang yang belum pernah melihat foto Obama-Ahmadinejad, semacam ingatan palsu terpercik di otak mereka, membenarkan peristiwa tersebut memang terjadi, meskipun sukar mengingat secara spesifik kejadiannya. Di sisi lain, bagi orang yang tahu bahwa foto tersebut palsu, otak mereka pun terpengaruh. Ini seperti saya meminta Anda untuk “jangan mengingat mantan!” Apa yang otak Anda pikirkan?

Ketika video rekaan menyebar di tengah masyarakat dan meskipun masyarakat tahu bahwa video tersebut palsu, aspek-aspek negatif yang termuat dalam video rekaan itu juga terpatri di otak. Apalagi, bila terpapar video rekaan yang sangat sukar dibuktikan asli atau palsu. Elizabeth Loftus, peneliti pada University of California Irvine, menyebut bahwa “jika seseorang terpapar video rekaan yang terlihat asli, bagaimana ia membuang memori tentang isi video tersebut?” Ingatan palsu, singkatnya, akhirnya tertanam di otak manusia.

Karena falsafah seeing is believing sudah lama tertanam di tubuh manusia, melalui video-video rekaan, benar salah akhirnya musnah.

Editor: Windu Jusuf

Masuk tirto.id

Masuk tirto.id