tirto.id - “Saya pernah melihat video seorang pengasuh bayi yang mencekik balita hingga tewas.”

Shawn Speagle punya profesi yang tak biasa: menjadi moderator konten di Facebook. Tugasnya adalah memantau, memeriksa, hingga menghapus konten-konten ekstrem (video ataupun meme) di platform tersebut. Itu artinya, setiap hari Speagle harus merecoki dirinya dengan berbagai macam kegilaan.

Kutipan di atas adalah kesaksian Speagle yang dilansir dalam laporan BBC pada Selasa (20/08/2019) lalu. Ia juga sempat menceritakan video lain yang pernah dilihat di awal masa kerjanya:

“Salah satu video pertama yang saya lihat adalah dua remaja yang tengah memegang ekor iguana lalu mereka membantingnya berkali-kali ke trotoar, sementara orang ketiga merekamnya. Iguana itu menjerit dan anak-anak itu tidak akan berhenti sampai iguananya mati.”

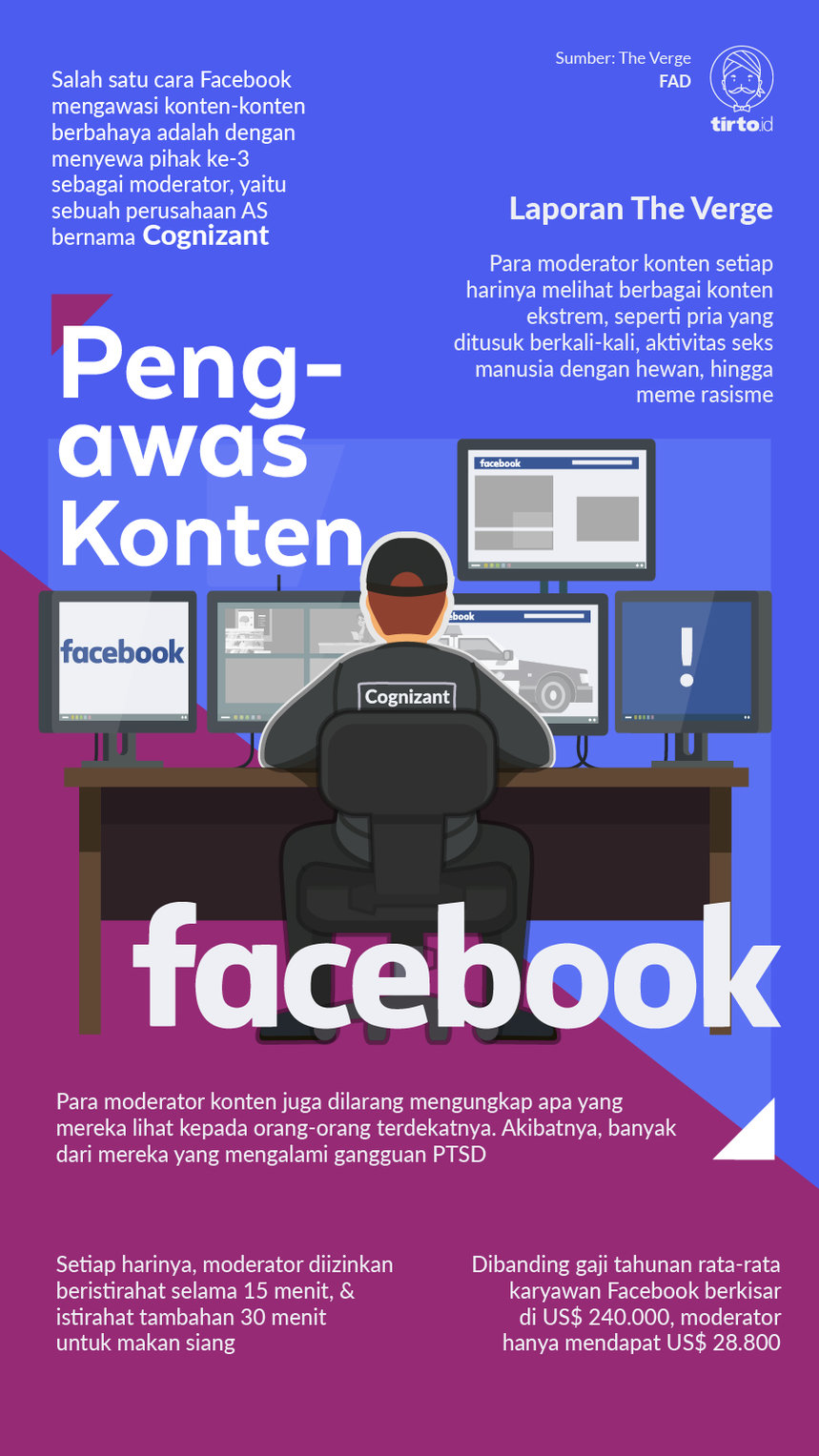

Speagle bekerja di Cognizant: sebuah perusahaan penyedia jasa layanan internet di AS. Facebook menyewa perusahaan dengan jumlah pekerja mencapai 800 orang tersebut-- untuk memantau konten yang melanggar ketentuan dan berbau negatif. Jika ada konten demikian, para moderator harus segera menghapusnya secara permanen atau menyembunyikannya hingga pengguna lain tidak dapat mengakses. Adapun nilai kontraknya adalah 200 juta USD selama dua tahun.

Tak jelas pula mengapa Facebook menyewa mereka. Sebab menurut laporan investigasi The Verge yang tayang 19 Juni 2019 lalu, Cognizant adalah perusahaan moderasi konten dengan kinerja terburuk seantero Amerika Utara. Mereka juga tidak pernah secara konsisten menegakkan kebijakan Facebook yang menargetkan akurasi 98 persen, sebagaimana diatur dalam kontrak perjanjian kerja keduanya. Adapun hasil maksimal yang dicapai Cognizant “hanyalah” 92 persen.

Cognizant memang menggunakan mesin kecerdasan buatan (AI) dalam sistem mereka, akan tetapi untuk bagian eksekusi tetaplah pekerja manusia yang dibutuhkan. Sejatinya, perusahaan seperti mereka juga banyak yang disewa oleh para platform raksasa lain seperti YouTube, Instagram, atau Twitter. Tugasnya pun sama belaka: memantau jutaan konten setiap hari lalu menghapusnya jika tidak sesuai kebijakan platform terkait.

Sebelum resmi bekerja, para moderator tersebut akan mendapat semacam buku panduan setebal ratusan halaman untuk dipelajari. Mereka juga diberikan pelatihan khusus untuk bbisa memutuskan konten mana yang harus dihapus dan mana yang harus diabaikan. Hal tersebut sempat dijelaskan oleh Moritz Riesewieck dan Hans Block, selaku sutradara The Cleaner, film dokumenter yang menceritakan sisi muram kehidupan moderator konten.

“Misalnya siapa yang memutuskan apa definisi dari teroris. Mereka punya daftar, mereka harus mempelajari daftar yang mengacu dari departemen keamanan dalam negeri AS," demikian ujar Riesewieck.

Persoalannya kemudian, selain semua hal itu wajib dipahami hanya dalam waktu satu hingga tiga pekan saja, para moderator konten ini juga amat rentan mengalami gangguan mental karena setiap hari harus menyaksikan banyak sekali konten ekstrem. Dari video pria yang ditusuk berkali-kali, aktivitas seks manusia dengan hewan (bestiality), penjagalan di wilayah perang, pornografi anak, bunuh diri yang disiarkan secara live, hingga meme rasisme.

Gangguan Mental Berujung Tuntutan kepada Facebook

Casey Newton, dalam laporan panjangnya berjudul The Trauma Floor, mewawancarai beberapa mantan karyawan Cognizant untuk mendapatkan info lain mengenai pekerjaan mereka. Ia mendapat fakta mengejutkan: para moderator konten harus menandatangani perjanjian untuk tidak boleh menceritakan seluruh konten ekstrem yang telah mereka lihat kepada siapapun, termasuk pasangan masing-masing.

Ketika bekerja, para moderator tersebut hanya mendapat waktu istirahat selama 45 menit yang dibagi ke dua tahap: 15 menit istirahat awal, 30 menit untuk makan siang. Mereka juga terus diawasi--bahkan untuk pergi ke toilet pun, para moderator ini harus dipantau oleh atasannya. Selain merasakan trauma akibat berbagai konten yang mereka lihat dan keberadaan yang terisolir tersebut, maka tidak mengherankan jika para moderator konten mengalami gangguan mental.

Sebagai pelampiasan, banyak dari mereka yang saling melontarkan humor gelap (seperti keinginan untuk bunuh diri, misalnya). Sebagian lain merokok ganja di kala istirahat, sementara tidak jarang pula antar karyawan berhubungan seks secara singkat di ruang laktasi di waktu senggang.

Chloe, salah seorang narasumber Newton, menceritakan bagaimana kisahnya ketika ia masih bekerja sebagai moderator konten di kantor cabang Cognizant di Phoenix, Arizona. Semula ia mendapat pelatihan selama tiga setengah pekan dan sepanjang waktu itu ia terus menerus disodori tiga jenis konten ekstrem: pidato kebencian, serangan kekerasan, dan pornografi terlarang. Chloe juga diminta untuk memahami 13 standar kebijakan komunitas Facebook.

Setelah tahapan itu selesai, Chloe menjalani tes di hadapan para moderator senior. Dan ketika tes baru berlangsung selama beberapa menit itulah ia mengalami serangan panik hebat yang membuatnya menangis keras dan kesulitan bernapas. Bagian terburuknya: Tidak ada satupun orang yang coba menenangkan dirinya.

Dalam film The Cleaner, kondisi mengerikan lain juga turut dijelaskan oleh beberapa mantan moderator di Cognizant. Misalnya saja ketika salah satu dari mereka ada yang pernah menonton video kucing yang dipanggang di dalam microwave, diuji ketahanan mentalnya dengan menonton video porno selama delapan jam nonstop, atau dalam sehari menyaksikan ratusan video kekerasan pada anak. Tidak bisa tidak, hal ini jelas berimbas berdampak pada psikologis para pegawai.

Riesewieck mengatakan: "Tentu saja hal itu bisa meninggalkan trauma yang bisa berujung ke post-traumatic stress disorder (PTSD).” PTSD adalah gangguan kesehatan mental yang terjadi setelah seseorang mengalami trauma yang berat. Biasanya sindrom ini kerap diidap oleh para veteran perang yang kembali ke lingkungan normal setelah menetap lama dalam wilayah peperangan.

Merasa tak sanggup karena terguncang mentalnya, beberapa moderator konten memutuskan berhenti. Namun, ada pula yang memberanikan diri untuk menuntut Facebook karena dinilai telah gagal menyediakan suasana dan fasilitas kerja yang layak bagi pegawainya. Seperti yang dilakukan oleh Erin Elder dan Gabriel Ramos, dua mantan moderator konten yang bekerja untuk Pro Unlimited, sebuah perusahaan lain yang juga bermitra dengan Facebook seperti Cognizant.

Gugatan class action terhadap Facebook tersebut awalnya diajukan pada September oleh Selena Scola, mantan moderator konten yang juga bekerja di Pro Unlimited Juni 2017 hingga Maret 2018. Steve Williams, pengacara firma hukum Joseph Saveri yang menangani kasus ini, mengatakan kepada Cnet:

"Kasus ini telah mengungkap mimpi buruk yang sebagian besar dari kita tidak tahu. Trauma dan bahaya yang diderita penggugat, serta orang lain yang melakukan pekerjaan moderasi konten.

Lalu bagaimana tanggapan Facebook? Selain membantah segala tuduhan, Facebook juga meminta agar kasus tersebut dihentikan. Salah seorang juru bicara mereka mengatakan bahwa seluruh pegawai memiliki akses tanpa batas ke fasilitas kesehatan mental. Mereka juga bisa berkonsultasi dengan para ahli terkait tingkat stres yang diderita.

“Kami sadar pekerjaan sebagai moderator konten akan sulit. Karenanya, kami menyediakan dukungan yang serius ke para pegawai, mulai dari pelatihan, berbagai manfaat khusus, hingga akses ke fasilitas psikologis. Semua tersedia secara in-house. Ada banyak pula area relaksasi di fasilitas kami agar pegawai tak stres.”

Editor: Nurul Qomariyah Pramisti